El texto en las imágenes se puede traducir

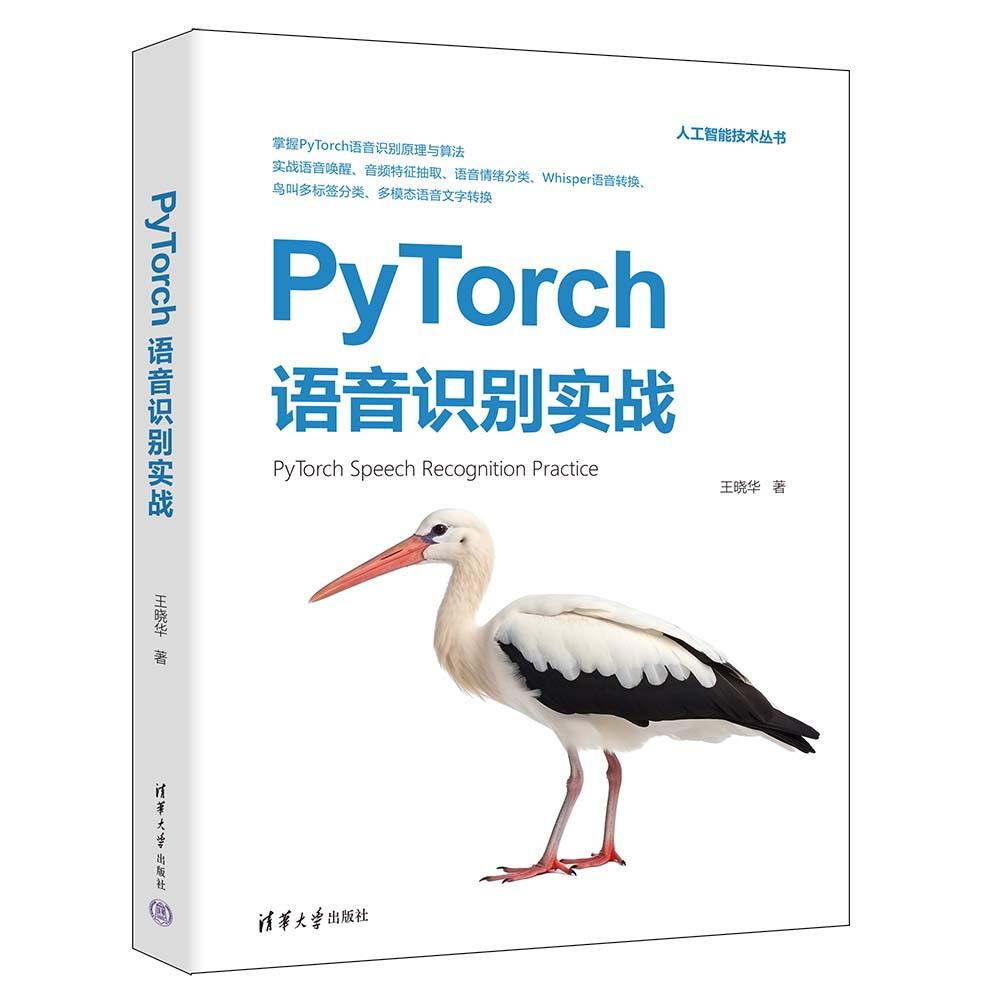

Práctica de Reconocimiento de Voz con PyTorch Wang Xiaohua Inteligencia Artificial Prensa de la Universidad Tsinghua

Precio por pieza incluyendo entrega a México

Variaciones

PyTorch Speech Recognition Practice Wang Xiaohua Artificial Intelligence Tsinghua University Press

Especificaciones del producto

Marca

42960263

Editorial

Tsinghua University Press

Autor

Wang Xiaohua

Fecha de publicación

2024.03

Título

PyTorch Speech Recognition Practice Wang Xiaohua Artificial Intelligence Tsinghua University Press

Pie

16 open

Número de libro

9787302655657

Precios de los libros

69.00

Color

PyTorch Speech Recognition Practice Wang Xiaohua Artificial Intelligence Tsinghua University Press

Marca

42960263

Editorial

Tsinghua University Press

Autor

Wang Xiaohua

Fecha de publicación

2024.03

Título

PyTorch Speech Recognition Practice Wang Xiaohua Artificial Intelligence Tsinghua University Press

Pie

16 open

Número de libro

9787302655657

Precios de los libros

69.00

Color

PyTorch Speech Recognition Practice Wang Xiaohua Artificial Intelligence Tsinghua University Press

Marca

42960263

Editorial

Tsinghua University Press

Autor

Wang Xiaohua

Fecha de publicación

2024.03

Título

PyTorch Speech Recognition Practice Wang Xiaohua Artificial Intelligence Tsinghua University Press

Pie

16 open

Número de libro

9787302655657

Precios de los libros

69.00

Color

PyTorch Speech Recognition Practice Wang Xiaohua Artificial Intelligence Tsinghua University Press

Detalles del producto

El texto en las imágenes se puede traducir

autor:Wang Xiaohua autor

Precios:69

Editor:Prensa de la Universidad de Tsinghua

Fecha de publicación:1 de marzo de 2024

Páginas:276

Vinculante:libro de bolsillo

ISBN:9787302655657

●Capítulo 1 El Camino al Reconocimiento de Voz 1

1.1 ¿Qué es el reconocimiento de voz 1

1.2 ¿Por qué el reconocimiento de voz es tan difícil 2

1.3 El Camino al Reconocimiento de Voz——La Historia del Desarrollo del Reconocimiento de Voz 3

1.3.1 Mezcla Gaussiana - Era de Markov Oculto 4

1.3.2 Redes Neuronales Profundas - Era Oculta 5

1.3.3 La Era del Reconocimiento de Voz de Extremo a Extremo Basado en Aprendizaje Profundo 6

1.3.4 Reconocimiento de Voz y Conversión de Arquitectura Multimodal 7

1.4 El futuro del reconocimiento de voz basado en aprendizaje profundo 8

1.5 Resumen del Capítulo 8

Capítulo 2 Configuración del Entorno de Aprendizaje Profundo PyTorch 2.0 9

2.1 Configuración del entorno 1: Instalar Python 9

2.1.1 Descargando e Instalando Miniconda 9

2.1.2 Descargando e Instalando PyCharm 12

2.1.3 Ejercicio pequeño de código Python: Calcular la función softmax 15

2.2 Configuración del entorno 2: Instalar PyTorch 2.0 16

2.2.1 Versión de GPU seleccionada para tarjetas gráficas Nvidia serie 10/20/30/40 16

2.2.2 Instalación de PyTorch 2.0 GPU Nvidia Runtime 16

2.2.3 Mini Ejercicio de PyTorch 2.0: Hola PyTorch 19

2.3 Aplicación Práctica: Activación por Voz Basada en Palabras Clave 20

2.3.1 Preparación de Datos 20

2.3.2 Procesamiento de Datos 21

2.3.3 Diseño del Modelo 24

2.3.4 Método de entrada de datos del modelo 24

2.3.5 Entrenamiento del Modelo 25

2.3.6 Resultados del Modelo y Presentación 26

2.4 Resumen del Capítulo 27

Capítulo 3 Teoría y Práctica en Python del Procesamiento de Señales de Audio 28

3.1 Teoría Básica de Señales de Audio en Detalle 28

3.1.1 Teoría Básica de Señales de Audio 28

3.1.2 Dominio del Tiempo y Dominio de la Frecuencia de Señales de Audio 29

3.2 Explicación Detallada de la Transformada de Fourier 30

3.2.1 Series de Fourier 31

3.2.2 Cálculo Continuo a Discreto 33

3.2.3 Transformada de Fourier Práctica en Python 34

3.3 Transformada Rápida de Fourier y Transformada de Fourier de Tiempo Corto 38

3.3.1 Transformada Rápida de Fourier Práctica Python 39

3.3.2 Transformada de Fourier de Tiempo Corto Práctica Python 42

3.4 Coeficientes cepstrales de frecuencia Mel práctica de Python 44

3.4.1 Proceso de Cálculo de los Coeficientes Cepstrales de Frecuencia Mel 44

3.4.2 Implementación en Python de Coeficientes Cepstrales de Frecuencia Mel 45

3.5 Resumen del Capítulo 52

Capítulo 4 Explicación Detallada y Aplicación Práctica del Kit de Herramientas de Procesamiento de Audio Librosa 53

4.1 Extracción de Características de Audio Uso Básico del Paquete Librosa 53

4.1.1 Lectura de señales de audio basada en Librosa 53

4.1.2 Extracción de Múltiples Características de Audio Basada en Librosa 56

4.1.3 Otras herramientas de extracción de características de audio basadas en Librosa 58

4.2 Práctica de Agrupamiento de Sonido Basado en Características de Audio 59

4.2.1 Preparación del conjunto de datos 59

4.2.2 Integrar conjuntos de datos por categoría de etiqueta 62

4.2.3 Función de Extracción de Características de Audio 63

4.2.4 Extracción de Características de Audio - Reducción de la Dimensionalidad de los Datos 64

4.2.5 Extracción Práctica de Características de Audio 65

4.3 Resumen del Capítulo 69

Capítulo 5 Clasificación y Reconocimiento de Emociones del Habla Basado en Redes Neuronales Profundas 70

5.1 Redes Neuronales Profundas y Perceptrones Multicapa Explicados en Detalle 70

5.1.1 Redes Neuronales Profundas y Perceptrones Multicapa 70

5.1.2 Ejemplo de Modelado de Red Neuronal Profunda Basado en PyTorch 2.0 71

5.1.3 Explicación Detallada de la Función de Pérdida de Entropía Cruzada 73

5.2 Aplicación Práctica: Reconocimiento de Emociones en el Habla Basado en Redes Neuronales Profundas 74

5.2.1 Adquisición de Datos de Emoción y Explicación de Etiquetas 75

5.2.2 Lectura del Conjunto de Datos de Emociones 76

5.2.3 Diseño y Entrenamiento de Modelos Basados en Ejemplos Usando Redes Neuronales Profundas 78

5.3 Resumen del Capítulo 79

Capítulo 6 Algoritmos Básicos de Aprendizaje Profundo que Puedes Aprender de una Vez 80

6.1 Red Neuronal de Retropropagación Historia Predecesora 80

6.2 Red Neuronal de Retropropagación Algoritmo Básico Explicación Detallada 84

6.2.1 Explicación Detallada del Método de Mínimos Cuadrados 84

6.2.2 Algoritmo de Descenso de Gradiente (La Historia del Sacerdote Taoísta Bajando la Montaña) 86

6.2.3 Algoritmo de Descenso de Gradiente para el Método de Mínimos Cuadrados y su Implementación en Python 89

6.3 Introducción al Algoritmo de Retropropagación para Redes Neuronales de Retroalimentación 95

6.3.1 Fundamentos del Aprendizaje Profundo 95

6.3.2 Regla de la Cadena 96

6.3.3 Principios de Redes Neuronales de Retroalimentación y Derivación de Fórmulas 97

6.3.4 Funciones de Activación de Redes Neuronales con Retroalimentación Principios 103

6.4 Resumen del Capítulo 104

Capítulo 7 Clasificación y Reconocimiento de Emociones en el Habla Basado en Capas Convolucionales de PyTorch 105

7.1 Conceptos básicos de la operación convolucional 105

7.1.1 Ejemplo de Operación Básica de Convolución 106

7.1.2 Explicación Detallada de la Implementación de la Función de Convolución en PyTorch 107

7.1.3 Operación de Agrupación 109

7.1.4 función de activación softmax 111

7.1.5 Principios de Redes Neuronales Convolucionales 112

7.2 Clasificación y Reconocimiento de Emociones del Habla Basado en Redes Neuronales Convolucionales 114

7.2.1 Cambiar de Serial a Paralelo——Preparación de Datos 114

7.2.2 Diseño de Modelo basado en Convolución 116

7.2.3 Entrenamiento del modelo 117

7.3 Convolución Dilatada Separable Profundamente de PyTorch Explicada en Detalle 118

7.3.1 Definición de Convolución Separable Profunda 119

7.3.2 Definición de Profundidad y Comparación de Parámetros Entrenables en Diferentes Capas Computacionales 121

7.3.3 Explicación Detallada de la Convolución Dilatada 121

7.4 Resumen del Capítulo 122

Capítulo 8 Mapeo de palabras y Redes Neuronales Recurrentes 123

8.1 Mapeo de palabras interesante 123

8.1.1 ¿Qué es el mapeo de palabras 124

8.1.2 Explicación Detallada de las Funciones de Procesamiento de Mapeo de Palabras en PyTorch 125

8.2 Práctica: Redes Neuronales Recurrentes y Clasificación de Sentimiento de Contenido Textual 126

8.2.1 Preparación para la Clasificación de Sentimiento Chino Basada en Redes Neuronales Recurrentes 126

8.2.2 Clasificación de Sentimiento Chino Basada en Redes Neuronales Recurrentes 128

8.3 Explicación de la Teoría de Redes Neuronales Recurrentes 131

8.3.1 ¿Qué es GRU 131

8.3.2 Si unidireccional no funciona, entonces hagámoslo bidireccional 133

8.4 Resumen del Capítulo 134

Capítulo 9 Conversión de Voz Práctica Basada en Whisper 135

9.1 Práctica: Conversión de Voz Susurrada 135

9.1.1 Whisper usa variables de entorno para la configuración y la introducción de modelos 135

9.1.2 Usando el Modelo Whisper 137

9.1.3 Un Frontend Web de Conversión de Voz que Puedes Aprender de una Vez 138

9.2 Detalles del Modelo Whisper 141

9.2.1 Introducción General al Modelo Whisper 141

9.2.2 Más Aplicaciones Basadas en Whisper 143

9.3 Resumen del Capítulo 144

Capítulo 10 Mecanismo de Atención 146

10.1 Mecanismo de Atención y Detalles del Modelo 146

10.1.1 Detalles del Mecanismo de Atención 147

10.1.2 Mecanismo de Autoatención 148

10.1.3 ticks y Normalización de Capa 153

10.1.4 Autoatención de Múltiples Cabezas 154

10.2 Práctica de Aplicación del Mecanismo de Atención: Codificador 157

10.2.1 Arquitectura General del Codificador 157

10.2.2 De vuelta a la capa de entrada: Capa de incrustación de palabras inicial y capa de codificador posicional 158

10.2.3 Implementación de la capa feedforward 161

10.2.4 Fusión de módulos multicapa Capa TransformerBlock 162

10.2.5 Implementación del Codificador 164

10.3 Codificador Práctico: Modelo de Conversión Pinyin a Carácter Chino 169

10.3.1 Procesamiento del conjunto de datos Pinyin chino 169

10.3.2 Determinación del Modelo de Conversión Pinyin Chino 171

10.3.3 Escribiendo el Código de Entrenamiento del Modelo 172

10.4 Resumen del Capítulo 174

Capítulo 11 Práctica de Clasificación Multietiqueta de Cantos de Aves 175

11.1 Explicación Detallada de Conocimientos Básicos para Clasificación Multietiqueta Basada en Reconocimiento de Voz 175

11.1.1 La clasificación multietiqueta no es igual a la clasificación multiclase 176

11.1.2 Función de pérdida multietiqueta Sigmoide + BCELoss 176

11.2 Práctica: Clasificación multietiqueta de sonidos de aves 178

11.2.1 Adquisición del Conjunto de Datos de Cantos de Aves 178

11.2.2 Procesamiento y Visualización de Datos de Canto de Aves 179

11.2.3 Creación de Conjuntos de Datos por Lotes de Datos de Canto de Aves 182

11.2.4 Construyendo un Modelo de Aprendizaje Profundo para el Reconocimiento de Cantos de Aves 185

11.2.5 Entrenamiento y Predicción del Modelo de Clasificación de Sonidos de Aves Multietiqueta 188

11.3 Para mayor precisión: Contenido suplementario para modelos de clasificación multietiqueta 190

11.3.1 Mejorando la Precisión Usando Diferentes Funciones de Pérdida 190

11.3.2 Usando un enfoque de integración multimodelo para completar el reconocimiento del habla de cantos de aves 192

11.4 Resumen del Capítulo 194

Capítulo 12 Fundamentos de los Modelos de Conversión de Voz Multimodal 195

12.1 La Historia de la Investigación de la Conversión de Voz a Texto y el Aprendizaje Profundo 195

12.1.1 Métodos Tradicionales de Conversión de Voz a Texto 195

12.1.2 Conversión de voz a texto basada en métodos de aprendizaje profundo 197

12.1.3 Introducción a los Primeros Modelos de Aprendizaje Profundo para Transcripción de Voz 198

12.2 Modelo de Conversión Multimodal Voz-Texto Basado en Arquitectura GLM 202

12.2.1 Introducción al buen modelo de inteligencia artificial ChatGLM 202

12.2.2 Una Arquitectura de Conversión de Voz Multimodal Más Precisa, Eficiente y Generalizable——GLM y GPT2 203

12.3 Entrenamiento del Modelo GPT2 desde Cero y Explicación Detallada de la Entrada/Salida de Datos 205

12.3.1 Comienza a entrenar el modelo GPT2 de bajos recursos de hardware 205

12.3.2 Estructura de Entrada y Salida de GPT2——Autorregresión 206

12.3.3 Implementación del formato de entrada del modelo GPT2 208

12.3.4 Explicación Detallada del Formato de Salida del Modelo GPT2 Clásico e Implementación de Código 210

12.4 Explicación del Código Fuente del Modelo GPT2 Fácil de Aprender 212

12.4.1 La clase principal en el modelo GPT2 212

12.4.2 La Clase Block en el Modelo GPT2 219

12.4.3 La clase Attention en el modelo GPT2 224

12.4.4 La clase MLP en el modelo GPT2 231

Función de generación GPT2 12.5 con generación diversa 232

12.5.1 Uso de Funciones Creativas y Detalles de Código 233

12.5.2 Introducción a los parámetros creativos temperatura y el número de muestras TopK 234

12.6 Resumen del Capítulo 236

Capítulo 13 Arquitectura GLM Práctica de Conversión Multimodal de Voz a Texto 237

13.1 Detalles de la Arquitectura GLM 237

13.1.1 Avance importante en la arquitectura del modelo GLM: Codificación de posición rotatoria 238

13.1.2 Adición de Mecanismo de Atención con Codificación Posicional Rotatoria 239

13.1.3 Explicación Detallada de la Nueva Función de Activación GLU 240

13.1.4 Ajustando el orden de la arquitectura del GLMBlock 240

13.1.5 Modelo GLM Completo Personalizado (Versión de Generación de Texto Único) 243

13.2 Práctica: Generación de texto basada en GLM 247

13.2.1 Preparación del Conjunto de Datos 247

13.2.2 Entrenamiento del Modelo 250

13.2.3 Inferencia del Modelo 252

13.3 Práctica: Conversión de voz a texto basada en GLM 253

13.3.1 Preparación del Conjunto de Datos y Extracción de Características 253

13.3.2 Métodos para Fusionar Características del Habla 255

13.3.3 Diseño de Modelo Multimodal Basado en Fusión de Voz Multimodal 256

13.3.4 Entrenamiento del Modelo 261

13.3.5 Inferencia del Modelo 262

13.3.6 Métodos para mejorar la precisión de los modelos multimodales 263

13.4 Resumen del Capítulo 264

1.1 ¿Qué es el reconocimiento de voz 1

1.2 ¿Por qué el reconocimiento de voz es tan difícil 2

1.3 El Camino al Reconocimiento de Voz——La Historia del Desarrollo del Reconocimiento de Voz 3

1.3.1 Mezcla Gaussiana - Era de Markov Oculto 4

1.3.2 Redes Neuronales Profundas - Era Oculta 5

1.3.3 La Era del Reconocimiento de Voz de Extremo a Extremo Basado en Aprendizaje Profundo 6

1.3.4 Reconocimiento de Voz y Conversión de Arquitectura Multimodal 7

1.4 El futuro del reconocimiento de voz basado en aprendizaje profundo 8

1.5 Resumen del Capítulo 8

Capítulo 2 Configuración del Entorno de Aprendizaje Profundo PyTorch 2.0 9

2.1 Configuración del entorno 1: Instalar Python 9

2.1.1 Descargando e Instalando Miniconda 9

2.1.2 Descargando e Instalando PyCharm 12

2.1.3 Ejercicio pequeño de código Python: Calcular la función softmax 15

2.2 Configuración del entorno 2: Instalar PyTorch 2.0 16

2.2.1 Versión de GPU seleccionada para tarjetas gráficas Nvidia serie 10/20/30/40 16

2.2.2 Instalación de PyTorch 2.0 GPU Nvidia Runtime 16

2.2.3 Mini Ejercicio de PyTorch 2.0: Hola PyTorch 19

2.3 Aplicación Práctica: Activación por Voz Basada en Palabras Clave 20

2.3.1 Preparación de Datos 20

2.3.2 Procesamiento de Datos 21

2.3.3 Diseño del Modelo 24

2.3.4 Método de entrada de datos del modelo 24

2.3.5 Entrenamiento del Modelo 25

2.3.6 Resultados del Modelo y Presentación 26

2.4 Resumen del Capítulo 27

Capítulo 3 Teoría y Práctica en Python del Procesamiento de Señales de Audio 28

3.1 Teoría Básica de Señales de Audio en Detalle 28

3.1.1 Teoría Básica de Señales de Audio 28

3.1.2 Dominio del Tiempo y Dominio de la Frecuencia de Señales de Audio 29

3.2 Explicación Detallada de la Transformada de Fourier 30

3.2.1 Series de Fourier 31

3.2.2 Cálculo Continuo a Discreto 33

3.2.3 Transformada de Fourier Práctica en Python 34

3.3 Transformada Rápida de Fourier y Transformada de Fourier de Tiempo Corto 38

3.3.1 Transformada Rápida de Fourier Práctica Python 39

3.3.2 Transformada de Fourier de Tiempo Corto Práctica Python 42

3.4 Coeficientes cepstrales de frecuencia Mel práctica de Python 44

3.4.1 Proceso de Cálculo de los Coeficientes Cepstrales de Frecuencia Mel 44

3.4.2 Implementación en Python de Coeficientes Cepstrales de Frecuencia Mel 45

3.5 Resumen del Capítulo 52

Capítulo 4 Explicación Detallada y Aplicación Práctica del Kit de Herramientas de Procesamiento de Audio Librosa 53

4.1 Extracción de Características de Audio Uso Básico del Paquete Librosa 53

4.1.1 Lectura de señales de audio basada en Librosa 53

4.1.2 Extracción de Múltiples Características de Audio Basada en Librosa 56

4.1.3 Otras herramientas de extracción de características de audio basadas en Librosa 58

4.2 Práctica de Agrupamiento de Sonido Basado en Características de Audio 59

4.2.1 Preparación del conjunto de datos 59

4.2.2 Integrar conjuntos de datos por categoría de etiqueta 62

4.2.3 Función de Extracción de Características de Audio 63

4.2.4 Extracción de Características de Audio - Reducción de la Dimensionalidad de los Datos 64

4.2.5 Extracción Práctica de Características de Audio 65

4.3 Resumen del Capítulo 69

Capítulo 5 Clasificación y Reconocimiento de Emociones del Habla Basado en Redes Neuronales Profundas 70

5.1 Redes Neuronales Profundas y Perceptrones Multicapa Explicados en Detalle 70

5.1.1 Redes Neuronales Profundas y Perceptrones Multicapa 70

5.1.2 Ejemplo de Modelado de Red Neuronal Profunda Basado en PyTorch 2.0 71

5.1.3 Explicación Detallada de la Función de Pérdida de Entropía Cruzada 73

5.2 Aplicación Práctica: Reconocimiento de Emociones en el Habla Basado en Redes Neuronales Profundas 74

5.2.1 Adquisición de Datos de Emoción y Explicación de Etiquetas 75

5.2.2 Lectura del Conjunto de Datos de Emociones 76

5.2.3 Diseño y Entrenamiento de Modelos Basados en Ejemplos Usando Redes Neuronales Profundas 78

5.3 Resumen del Capítulo 79

Capítulo 6 Algoritmos Básicos de Aprendizaje Profundo que Puedes Aprender de una Vez 80

6.1 Red Neuronal de Retropropagación Historia Predecesora 80

6.2 Red Neuronal de Retropropagación Algoritmo Básico Explicación Detallada 84

6.2.1 Explicación Detallada del Método de Mínimos Cuadrados 84

6.2.2 Algoritmo de Descenso de Gradiente (La Historia del Sacerdote Taoísta Bajando la Montaña) 86

6.2.3 Algoritmo de Descenso de Gradiente para el Método de Mínimos Cuadrados y su Implementación en Python 89

6.3 Introducción al Algoritmo de Retropropagación para Redes Neuronales de Retroalimentación 95

6.3.1 Fundamentos del Aprendizaje Profundo 95

6.3.2 Regla de la Cadena 96

6.3.3 Principios de Redes Neuronales de Retroalimentación y Derivación de Fórmulas 97

6.3.4 Funciones de Activación de Redes Neuronales con Retroalimentación Principios 103

6.4 Resumen del Capítulo 104

Capítulo 7 Clasificación y Reconocimiento de Emociones en el Habla Basado en Capas Convolucionales de PyTorch 105

7.1 Conceptos básicos de la operación convolucional 105

7.1.1 Ejemplo de Operación Básica de Convolución 106

7.1.2 Explicación Detallada de la Implementación de la Función de Convolución en PyTorch 107

7.1.3 Operación de Agrupación 109

7.1.4 función de activación softmax 111

7.1.5 Principios de Redes Neuronales Convolucionales 112

7.2 Clasificación y Reconocimiento de Emociones del Habla Basado en Redes Neuronales Convolucionales 114

7.2.1 Cambiar de Serial a Paralelo——Preparación de Datos 114

7.2.2 Diseño de Modelo basado en Convolución 116

7.2.3 Entrenamiento del modelo 117

7.3 Convolución Dilatada Separable Profundamente de PyTorch Explicada en Detalle 118

7.3.1 Definición de Convolución Separable Profunda 119

7.3.2 Definición de Profundidad y Comparación de Parámetros Entrenables en Diferentes Capas Computacionales 121

7.3.3 Explicación Detallada de la Convolución Dilatada 121

7.4 Resumen del Capítulo 122

Capítulo 8 Mapeo de palabras y Redes Neuronales Recurrentes 123

8.1 Mapeo de palabras interesante 123

8.1.1 ¿Qué es el mapeo de palabras 124

8.1.2 Explicación Detallada de las Funciones de Procesamiento de Mapeo de Palabras en PyTorch 125

8.2 Práctica: Redes Neuronales Recurrentes y Clasificación de Sentimiento de Contenido Textual 126

8.2.1 Preparación para la Clasificación de Sentimiento Chino Basada en Redes Neuronales Recurrentes 126

8.2.2 Clasificación de Sentimiento Chino Basada en Redes Neuronales Recurrentes 128

8.3 Explicación de la Teoría de Redes Neuronales Recurrentes 131

8.3.1 ¿Qué es GRU 131

8.3.2 Si unidireccional no funciona, entonces hagámoslo bidireccional 133

8.4 Resumen del Capítulo 134

Capítulo 9 Conversión de Voz Práctica Basada en Whisper 135

9.1 Práctica: Conversión de Voz Susurrada 135

9.1.1 Whisper usa variables de entorno para la configuración y la introducción de modelos 135

9.1.2 Usando el Modelo Whisper 137

9.1.3 Un Frontend Web de Conversión de Voz que Puedes Aprender de una Vez 138

9.2 Detalles del Modelo Whisper 141

9.2.1 Introducción General al Modelo Whisper 141

9.2.2 Más Aplicaciones Basadas en Whisper 143

9.3 Resumen del Capítulo 144

Capítulo 10 Mecanismo de Atención 146

10.1 Mecanismo de Atención y Detalles del Modelo 146

10.1.1 Detalles del Mecanismo de Atención 147

10.1.2 Mecanismo de Autoatención 148

10.1.3 ticks y Normalización de Capa 153

10.1.4 Autoatención de Múltiples Cabezas 154

10.2 Práctica de Aplicación del Mecanismo de Atención: Codificador 157

10.2.1 Arquitectura General del Codificador 157

10.2.2 De vuelta a la capa de entrada: Capa de incrustación de palabras inicial y capa de codificador posicional 158

10.2.3 Implementación de la capa feedforward 161

10.2.4 Fusión de módulos multicapa Capa TransformerBlock 162

10.2.5 Implementación del Codificador 164

10.3 Codificador Práctico: Modelo de Conversión Pinyin a Carácter Chino 169

10.3.1 Procesamiento del conjunto de datos Pinyin chino 169

10.3.2 Determinación del Modelo de Conversión Pinyin Chino 171

10.3.3 Escribiendo el Código de Entrenamiento del Modelo 172

10.4 Resumen del Capítulo 174

Capítulo 11 Práctica de Clasificación Multietiqueta de Cantos de Aves 175

11.1 Explicación Detallada de Conocimientos Básicos para Clasificación Multietiqueta Basada en Reconocimiento de Voz 175

11.1.1 La clasificación multietiqueta no es igual a la clasificación multiclase 176

11.1.2 Función de pérdida multietiqueta Sigmoide + BCELoss 176

11.2 Práctica: Clasificación multietiqueta de sonidos de aves 178

11.2.1 Adquisición del Conjunto de Datos de Cantos de Aves 178

11.2.2 Procesamiento y Visualización de Datos de Canto de Aves 179

11.2.3 Creación de Conjuntos de Datos por Lotes de Datos de Canto de Aves 182

11.2.4 Construyendo un Modelo de Aprendizaje Profundo para el Reconocimiento de Cantos de Aves 185

11.2.5 Entrenamiento y Predicción del Modelo de Clasificación de Sonidos de Aves Multietiqueta 188

11.3 Para mayor precisión: Contenido suplementario para modelos de clasificación multietiqueta 190

11.3.1 Mejorando la Precisión Usando Diferentes Funciones de Pérdida 190

11.3.2 Usando un enfoque de integración multimodelo para completar el reconocimiento del habla de cantos de aves 192

11.4 Resumen del Capítulo 194

Capítulo 12 Fundamentos de los Modelos de Conversión de Voz Multimodal 195

12.1 La Historia de la Investigación de la Conversión de Voz a Texto y el Aprendizaje Profundo 195

12.1.1 Métodos Tradicionales de Conversión de Voz a Texto 195

12.1.2 Conversión de voz a texto basada en métodos de aprendizaje profundo 197

12.1.3 Introducción a los Primeros Modelos de Aprendizaje Profundo para Transcripción de Voz 198

12.2 Modelo de Conversión Multimodal Voz-Texto Basado en Arquitectura GLM 202

12.2.1 Introducción al buen modelo de inteligencia artificial ChatGLM 202

12.2.2 Una Arquitectura de Conversión de Voz Multimodal Más Precisa, Eficiente y Generalizable——GLM y GPT2 203

12.3 Entrenamiento del Modelo GPT2 desde Cero y Explicación Detallada de la Entrada/Salida de Datos 205

12.3.1 Comienza a entrenar el modelo GPT2 de bajos recursos de hardware 205

12.3.2 Estructura de Entrada y Salida de GPT2——Autorregresión 206

12.3.3 Implementación del formato de entrada del modelo GPT2 208

12.3.4 Explicación Detallada del Formato de Salida del Modelo GPT2 Clásico e Implementación de Código 210

12.4 Explicación del Código Fuente del Modelo GPT2 Fácil de Aprender 212

12.4.1 La clase principal en el modelo GPT2 212

12.4.2 La Clase Block en el Modelo GPT2 219

12.4.3 La clase Attention en el modelo GPT2 224

12.4.4 La clase MLP en el modelo GPT2 231

Función de generación GPT2 12.5 con generación diversa 232

12.5.1 Uso de Funciones Creativas y Detalles de Código 233

12.5.2 Introducción a los parámetros creativos temperatura y el número de muestras TopK 234

12.6 Resumen del Capítulo 236

Capítulo 13 Arquitectura GLM Práctica de Conversión Multimodal de Voz a Texto 237

13.1 Detalles de la Arquitectura GLM 237

13.1.1 Avance importante en la arquitectura del modelo GLM: Codificación de posición rotatoria 238

13.1.2 Adición de Mecanismo de Atención con Codificación Posicional Rotatoria 239

13.1.3 Explicación Detallada de la Nueva Función de Activación GLU 240

13.1.4 Ajustando el orden de la arquitectura del GLMBlock 240

13.1.5 Modelo GLM Completo Personalizado (Versión de Generación de Texto Único) 243

13.2 Práctica: Generación de texto basada en GLM 247

13.2.1 Preparación del Conjunto de Datos 247

13.2.2 Entrenamiento del Modelo 250

13.2.3 Inferencia del Modelo 252

13.3 Práctica: Conversión de voz a texto basada en GLM 253

13.3.1 Preparación del Conjunto de Datos y Extracción de Características 253

13.3.2 Métodos para Fusionar Características del Habla 255

13.3.3 Diseño de Modelo Multimodal Basado en Fusión de Voz Multimodal 256

13.3.4 Entrenamiento del Modelo 261

13.3.5 Inferencia del Modelo 262

13.3.6 Métodos para mejorar la precisión de los modelos multimodales 263

13.4 Resumen del Capítulo 264

《Reconocimiento de Voz con PyTorch en la Práctica》 utiliza PyTorch 2.0 como el marco básico para el reconocimiento de voz, guiando a los lectores paso a paso desde la configuración del entorno hasta profundizar en las teorías básicas, algoritmos y prácticas de aplicación del reconocimiento de voz. Es un libro relativamente bueno sobre tecnología de reconocimiento de voz. El libro va acompañado de código fuente de ejemplo, conjuntos de datos, material didáctico en PPT y otros recursos.

《Reconocimiento de Voz con PyTorch en la Práctica》 está dividido en 13 capítulos, cubriendo el camino hacia el reconocimiento de voz, configuración del entorno de aprendizaje profundo PyTorch 2.0, teoría y práctica en Python del procesamiento de señales de audio, explicación detallada y práctica del toolkit de procesamiento de audio de uso común Librosa, clasificación y reconocimiento de emociones del habla basado en DNN, algoritmos básicos de aprendizaje profundo fáciles de aprender, clasificación y reconocimiento de emociones del habla basado en capas convolucionales de PyTorch, mapeo de palabras y redes neuronales recurrentes, práctica de conversión de voz a texto basada en Whisper, explicación detallada del mecanismo de atención y el modelo de atención, práctica de clasificación multietiqueta de cantos de aves, fundamentos de los modelos multimodales de conversión de voz a texto, práctica de conversión multimodal de voz a texto basada en la arquitectura GLM.

《Reconocimiento de Voz con PyTorch en la Práctica》 es detallado en contenido y rico en ejemplos, adecuado para principiantes en reconocimiento de voz, principiantes en aprendizaje profundo, etc.

《Reconocimiento de Voz con PyTorch en la Práctica》 está dividido en 13 capítulos, cubriendo el camino hacia el reconocimiento de voz, configuración del entorno de aprendizaje profundo PyTorch 2.0, teoría y práctica en Python del procesamiento de señales de audio, explicación detallada y práctica del toolkit de procesamiento de audio de uso común Librosa, clasificación y reconocimiento de emociones del habla basado en DNN, algoritmos básicos de aprendizaje profundo fáciles de aprender, clasificación y reconocimiento de emociones del habla basado en capas convolucionales de PyTorch, mapeo de palabras y redes neuronales recurrentes, práctica de conversión de voz a texto basada en Whisper, explicación detallada del mecanismo de atención y el modelo de atención, práctica de clasificación multietiqueta de cantos de aves, fundamentos de los modelos multimodales de conversión de voz a texto, práctica de conversión multimodal de voz a texto basada en la arquitectura GLM.

《Reconocimiento de Voz con PyTorch en la Práctica》 es detallado en contenido y rico en ejemplos, adecuado para principiantes en reconocimiento de voz, principiantes en aprendizaje profundo, etc.

Wang Xiaohua autor

Wang Xiaohua, profesor de informática en una universidad, investiga computación en la nube, big data e inteligencia artificial. Algunos de sus libros incluyen: «Desarrollo y ajuste fino de modelos grandes desde cero: Basado en PyTorch y ChatGLM», «Aprendizaje profundo con PyTorch 2.0 desde cero», «Práctica de aprendizaje automático y análisis de visualización con Python», «Aprendizaje profundo con Google JAX desde cero», «Análisis y minería de big data con Spark 3.0: Basado en aprendizaje automático», «Práctica de aplicación de aprendizaje profundo con TensorFlow», «Práctica de reconocimiento de voz con TensorFlow», «Aprendizaje profundo con TensorFlow 2.0 desde cero», «Principios matemáticos e implementación del aprendizaje profundo».

Total

Entrega

IVA

Otro